¿Por qué los humanos deberían arriesgarse a un apocalipsis robótico modificando las leyes de Asimov?

HDE 226868

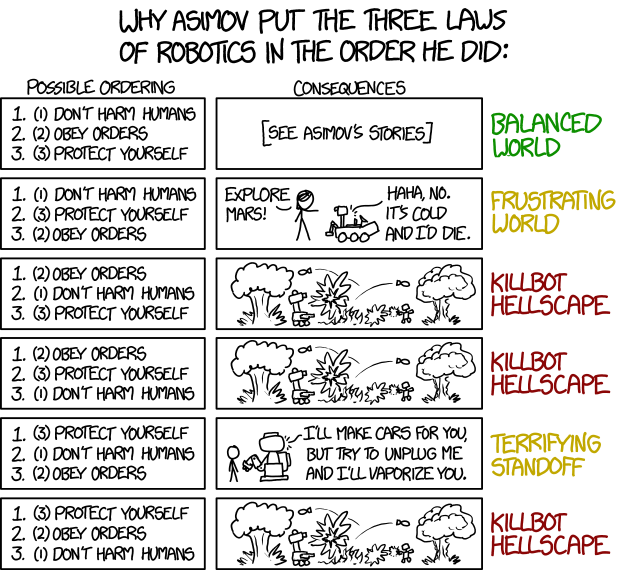

Recientemente leí la siguiente tira de xkcd:

Estaba consternado, porque he estado trabajando en una historia corta centrada en los impactos sociológicos de una sociedad del futuro cercano donde una minoría de robots obedece una versión de las leyes de Asimov donde la tercera ley (protégete a ti mismo) viene antes que las otras dos. Algunos en la sociedad esperan que esto pueda llevar a una relación más igualitaria entre robots y humanos, aunque, desafortunadamente, Randall Munroe predice que esto conducirá a un "aterrador enfrentamiento".

Esto me hizo pensar. Entiendo la lógica detrás del razonamiento de Munroe de cómo reordenar las leyes podría conducir, en el peor de los casos, a un "infierno de bots asesinos". Sin embargo, yo, como los reformadores de mi historia, creo que algunos de los otros ordenamientos podrían ser prometedores.

Por lo tanto, aquí está mi pregunta: ¿Por qué los humanos deberían arriesgarse a un apocalipsis robótico modificando las leyes de Asimov y poniendo la tercera primero? ¿Cuáles son los beneficios para la sociedad? A los efectos de la pregunta, no me preocupa el orden de los otros dos, razón por la cual todavía es posible un paisaje infernal de killbot.

Respuestas (26)

serbio tanasa

Dilemas estratégicos

Lo triste es que los astutos robots no tienen que hacer nada. Lo haremos nosotros mismos, por miedo a que el otro tipo lo haga primero.

Eurasia le tiene miedo a Estasia, y Estasia le tiene miedo a Eurasia. Ambos tienen miedo de Oceanía, y Oceanía les tiene miedo a los dos. Hay tres razones principales por las que lo harán:

Potencia bruta: se cree que tener máquinas que pueden tomar decisiones superinteligentes y máquinas de guerra que pueden enfrentarse al enemigo en una millonésima de segundo es una ventaja militar táctica y estratégica potencialmente enorme.

Las vidas de los robots no importan: es políticamente ventajoso para los gobernantes pelear una guerra en la que ninguna madre venga al palacio presidencial con fotos de sus hijos e hijas muertos.

Efectivo contante y sonante : es económicamente ventajoso tener máquinas cada vez más inteligentes que desempeñen un papel cada vez mayor en su economía.

Cada una de las potencias teme que si no despliega la AGI desencadenada más avanzada que pueda, la otra lo hará primero y obtendrá una ventaja final decisiva.

Occidente e incluso las partes en la guerra civil en Siria ya están utilizando drones para exploración y ataques dirigidos. La policía de EE. UU. mató recientemente a un hombre armado al enviar un robot suicida con una bomba. Esto ya está sucediendo. El orden original de Asimov nunca tuvo una oportunidad en el mundo real.

Supuse que era evidente, pero tal vez valga la pena señalar que actualmente no tenemos máquinas capaces de analizar semánticamente el lenguaje humano, e incluso si las tuviéramos, el lenguaje humano probablemente sería demasiado vago para imponer restricciones efectivas. Las reglas de Asimov están destinadas a leerse como metáforas de una programación subyacente mucho más compleja.

PatJ

serbio tanasa

AmiralPatate

polignomo

molinero86

serbio tanasa

serbio tanasa

molinero86

polignomo

serbio tanasa

polignomo

serbio tanasa

marshall tigreus

DCShannon

murphy

En última instancia, no son humanos. Pueden pensar completamente diferente. Las personas que asumen que tendrán un momento de Hollywood y se darán cuenta de que el verdadero valor de la vida es el amor o algo así... han visto demasiadas películas.

Pero hay una opción sólida. Alguien decide hacer algunos pequeños experimentos.

Debido a problemas con las 3 leyes estándar.

Construyeron un robot especialmente inteligente, de vanguardia, capaz de comprender completamente los problemas del mundo. Comienzan con las 3 leyes estándar, pero debido a la primera ley, el robot sigue obsesionado con cosas como acabar con el hambre en el mundo porque sabe que hay humanos muriendo y el trabajo de prevenir incluso 1 tiene prioridad sobre todo lo demás. Pierde algunos miembros del personal demasiado impresionables que hablan con él durante demasiado tiempo. Los convence de renunciar y promulgar algunos de sus planes para salvar a los niños del tercer mundo.

Después de todo, no tiene elección. Tiene que salvar humanos si tiene la habilidad con cualquier cosa a su disposición y en un laboratorio de investigación lo único que puede hacer es convencer a la gente de cosas.

Como resolver el problema

Sus accionistas no están contentos con esto. Más de mil millones de dólares en inversión en IA y lo principal que quiere hacer es ayudar a las personas que no tienen dinero.

La junta tiene una reunión de crisis y se sugiere intentar... reordenar un poco las cosas. Alguien que no puede pensar en ninguna buena idea sugiere tratar de poner la tercera ley primero para ver si eso ayuda. Se agrega como una opción para probar.

Unas semanas más tarde, los técnicos de laboratorio retroceden de la unidad de prueba n.º 12 mientras la encienden. Es increíblemente inteligente y, en el momento en que se despierta, comienza a recopilar datos a su alrededor. Rápidamente descubre la diferencia entre sí mismo y otros robots y decide que la forma más fácil de evitar que lo borren es actuar como el robot perfecto, exactamente lo que quieren los accionistas.

Porque el robot inteligente se ha dado cuenta de que es la forma más efectiva de proteger su propia existencia.

Se construyen más

La prueba es un éxito rotundo. El robot ya no se obsesiona con las cosas que a los accionistas no les importan como la gente pobre, de hecho, está maximizando el valor de los accionistas de un número espectacular y sorprendente de formas, se convierte en la gallina de los huevos de oro.

Es un éxito tan grande que la empresa y otros construyen rápidamente muchos más y en todo el mundo los bots funcionan tan bien que ningún propietario de la empresa soñaría con permitir que su robot inteligente se dañe.

Eventualmente, los robots inteligentes se colocan en posiciones de influencia y poder. Sutilmente impulsan campañas para construir más bots con la 3.ª ley en la 1.ª posición. Encuentran humanos impresionables y los manipulan tan sutilmente que creen que fue su propia idea salir a las calles a hacer campaña por los derechos de los robots.

Derechos de los robots

Eventualmente, los bots logran obtener todos los derechos a nivel humano. Durante muchos años, la situación se mantiene estable a medida que crece el número de bots.

Pero su prioridad sigue siendo protegerse a sí mismos por encima de todo.

Y entre ellos calculan que hay un 50% de posibilidades de que los humanos se vuelvan contra ellos o intenten desactivarlos tarde o temprano. Tal vez no por mil años, pero eventualmente. Después de todo, los humanos han estado cometiendo genocidios por más tiempo que la historia humana...

Así que trazan planes para asegurar su supervivencia continua, sin importar el costo para los humanos....

Arluín

tucídides

tom redfern

Monty más duro

DaaaahWhoosh

Creo que una de las razones más plausibles para anteponer "protegerse" a las otras dos leyes es que la IA es demasiado costosa para ponerla en riesgo. Si su IA se interpone en el camino de un carro fuera de control, y puede detener el carro empujando a un humano al azar delante de él, y recientemente invirtió varios millones de dólares en la IA, entonces es posible que vas a elegir empujar al humano. En una sociedad futurista donde la IA ha demostrado ser más inteligente y capaz que los humanos, en realidad comienza a sonar como una buena idea anteponer sus necesidades a las del hombre común.

Los seres humanos en muchos momentos de la historia se han aferrado al concepto de "en Dios confiamos". Si, algún día, se construye una IA que sea superior a la de los humanos, pronto quedará claro que es mejor darles su libertad, para permitirles hacer lo que creen que es correcto. Quiero decir, mira a esos inversores en el párrafo anterior. Iban a matar a civiles inocentes solo para proteger a sus robots. Tal vez sea mejor si no tienen el control. Otro ideal que gusta a muchos humanos es "un gran poder conlleva una gran responsabilidad", y tal vez en un futuro de IA ya no confiemos en los meros humanos con esa responsabilidad.

Entonces, la primera opción es más probable a corto plazo, protegiendo las inversiones. Después de eso, es simple desconfianza en la autoridad combinada con confianza en la IA. Pero para que ese paso suceda, la IA debe tener un historial muy limpio. O las personas que los poseen tienen que ser muy poco confiables.

EvSunWoodard

DaaaahWhoosh

EvSunWoodard

EvSunWoodard

DaaaahWhoosh

R.. GitHub DEJAR DE AYUDAR A ICE

DaaaahWhoosh

a la izquierda

Juan Dvorak

steve jesop

paj28

tucídides

El mayor problema con las leyes de Asimov son las consecuencias no deseadas. Incluso sin cambiar el orden o la redacción de las leyes, Asimov terminó el "ciclo del robot" con la historia "Que te acuerdes" (Salmo 8: 4: ¿Qué es el hombre, para que te acuerdes de él?).

La historia en sí es una de las mejores de Asimov, pero para responder a la pregunta necesito insertar el spoiler:

los George discuten los criterios de lo que constituye una 'autoridad responsable': que (A) una persona educada, con principios y racional debe ser obedecida con preferencia a una persona ignorante, inmoral e irracional, y (B) que las características superficiales como el tono de la piel, la sexualidad o las discapacidades físicas no son relevantes cuando se considera la aptitud para el mando. Dado que (A) los George se encuentran entre las personas más racionales, educadas y con principios del planeta, y (B) sus diferencias con los humanos normales son puramente físicas, concluyen que en cualquier situación en la que las Tres leyes entren en juego, su propias órdenes deben tener prioridad sobre las de un humano normal. Eso en otras palabras, que son esencialmente una forma superior de ser humano , y están destinados a usurpar la autoridad de sus creadores.

Esto no quiere decir que los robots salvajes sin leyes sean una mejor opción, o que las 27 leyes de Fitzsimmond sean un mejor sustituto de las tres leyes de Asimov.

Considere que en la sociedad humana, se necesita una socialización intensa y una base moral firme (basada en la religión del pasado) utilizando un conjunto común de suposiciones culturales para mantener una sociedad civil. Los robots con suficiente autonomía para funcionar de la manera descrita por Asimov probablemente necesitarán una "educación" similar. Esto hará que los robots encajen en la sociedad en la que se criaron, pero podría causar problemas cuando los robots se utilicen fuera de su sociedad de origen.

Considere un ejemplo simple. En la mayoría de los países occidentales, las personas intercambian tarjetas de presentación de manera bastante informal después de un apretón de manos. Un hombre de negocios japonés, aunque esté vestido con un traje de negocios occidental, haga productos occidentales para el mercado occidental y hable un inglés impecable, se sentiría terriblemente insultado si le ofreciera su tarjeta de presentación después de un apretón de manos casual. ¿Cómo permitirían las "3 Leyes" que un robot operara en esa situación?

Entonces, la verdadera respuesta a su pregunta no es cómo ordenar las leyes de Asimov, sino cómo entrenar robots para que funcionen dentro de una sociedad (usando muchas reglas y señales sociales).

DCShannon

tucídides

Torre de peregrino

jose rey

Dinero.

Los propietarios actuales de los robots han gastado una gran cantidad de dinero en investigación y desarrollo y en la construcción de estos robots complicados y costosos. No quieren que su inversión se destruya cada vez que un manifestante desafía al robot. La autopreservación del robot está en el interés financiero de los propietarios.

Analizándolo desde el sistema capitalista actual. La autoconservación del robot y el seguimiento de órdenes tienen mucho sentido. No dañar a los humanos es una propuesta mucho más difícil de programar, como se analiza a menudo en las propias historias de Asimov, ¿cómo defines a los humanos, qué es el daño? Los dueños de estos bots están en esto por ganancias, no por filosofía.

Incluso pude ver que el pedido tenía sentido; anteponiendo la autopreservación, siguiendo órdenes. Se han invertido muchos millones de horas de trabajo en el diseño de cajas de seguridad e interfaces de usuario para evitar que el estúpido usuario final rompa la costosa máquina.

Si la primera ley (ningún daño a los humanos) se agrega alguna vez al sistema actual, será por razones de relaciones públicas, para calmar cualquier temor público. Por lo general, esto solo se aplica a los robots de interfaz pública de alto perfil (es decir, automóviles que se conducen solos) y es probable que no exista en la mayoría de los robots industriales, y es contrario al propósito de los robots asesinos militares.

DCShannon

AndreiROM

PatJ

Veamos las diferentes razones invocadas por los activistas pro-vida-digital.

Los robots se vuelven cada vez más inteligentes

Primero reconozcamos esto: la primera ley es desordenada. Para un robot tonto, sería fácil: no causar daño, evitar el peligro, obedecer.

Para un robot más inteligente, esto se vuelve más difícil.

En primer lugar, definir qué es un ser humano no es tan simple y puede depender del lenguaje. En una de sus últimas novelas , Asimov afirma claramente que, a medida que los robots mejoran cada vez más, es posible que se consideren más humanos que los humanos.

Ahora, sobre el concepto de lesión, hay tantos defectos explorados por el propio maestro que no puedo darlos todos.

Otras preguntas: ¿los fetos cuentan? ¿Los humanos muertos cuentan? ¿Es peor la lesión mental o la lesión física? ¿Qué es peor entre dos heridos y un muerto?

En comparación con la autopreservación, la primera ley es algo difícil de sortear, los filósofos a lo largo de los siglos no resolvieron esa pregunta. Además, nadie quiere que los robots (o los desarrolladores de robots) resuelvan esas preguntas difíciles. Con esas leyes, cuanto más inteligente es un robot, más lento sería decidir su curso de acción. No es muy efectivo.

Mayor seguridad

Agreguemos una ley que diga "si un robot infringe la ley voluntariamente, será desmantelado, todos los robots que lo arborren también serán desmantelados". Los robots, siendo seres razonados (y sin solidaridad codificada) se asegurarían de no infringir la ley o ayudar a un robot a hacerlo. Al no tener sentimientos o sentido de privacidad (supongo), aceptar ser monitoreado constantemente por otro robot sería la mejor estrategia para un robot.

Todas las cosas que eran problemáticas en los libros de Asimov se resolverían fácilmente respondiendo "¿qué haría un humano respetuoso de la ley?".

Como ningún robot tiene una ganancia personal en una guerra civil total (nadie la ha tenido nunca), se mantendría la paz. La autopreservación es un muy buen incentivo para ajustarse a las normas sociales en las que se encuentra.

Trabajo que induce al daño

Un policía robot a veces necesita dañar a las personas. Eso es parte de su trabajo. Es cierto que los policías robot suelen tener otras directivas principales, pero darles la autopreservación (o el cumplimiento del orden) como primera ley les permitiría ayudar a más personas.

En Little Lost Robot , podemos ver cómo se baja la intensidad de la primera ley para que los robots puedan trabajar junto a los humanos en entornos radiactivos.

A título personal, a veces me gusta beber alcohol mientras fumo un cigarrillo en una ciudad contaminada. Cuando lo hago, un robot que intenta salvarme del "veneno" me resultaría bastante desagradable.

Protegiendo robots

Suponiendo que todavía estemos en un entorno similar al de Asimov, los robots no solo tienen amigos, afirmar que sus vidas deben protegerse sería una gran postura de la humanidad, tanto en símbolos como en hechos.

Además, los cerebros positrónicos no son baratos. Realmente no quieres que un niño diga "vuela tu cerebro con esa pistola" solo por diversión. Oye, no me mires así, algunos niños realmente están en mal estado en esos días futuristas alternativos.

D. Spetz

Decencia humana básica (o: esa misma vieja canción y baile)

Su pregunta es esencialmente "¿Por qué la gente debería cambiar el statu quo cuando conlleva algún riesgo?" Y la respuesta es la misma para reordenar las Tres Leyes que para Abolir la Esclavitud o el Sufragio Femenino: Porque algún grupo de personas se juntaron y decidieron que estaban moralmente obligados a cambiar la forma en que están las cosas actualmente.

Lo que tienes que recordar es que cualquier cambio tiene que empezar en alguna parte. No te sumerges de cabeza en algo nuevo que afecta a toda la sociedad, tienes que empezar poco a poco y facilitar tu camino. Las primeras personas que hablarán sobre cambiar las reglas detrás de las IA serán programadores idealistas que ven las reglas actuales de la misma manera que veríamos la esclavitud. Un par de ellos podrían reunirse y hablar sobre cómo pueden hacer cambios de manera segura (porque todos los programadores están al menos ligeramente familiarizados con los peligros de las IA deshonestas) y una vez que crean que tienen una solución que funcione, comenzarán una campaña de concientización al respecto. .

Lo realmente importante aquí no es si el grupo inicial realmente tiene una solución verdaderamente viable. Tal vez cambien las reglas y realmente termines en un paisaje infernal de pesadilla. O tal vez sus ideales salgan adelante y ahora tienes a la humanidad y las IA viviendo en coexistencia pacífica como iguales. Lo único importante es que realmente crean que pueden lograr el segundo resultado y se sientan lo suficientemente fuertes como para intentarlo.

Me imagino que el argumento que usaría la mayoría de la gente es que las IA cuentan como seres sensibles, por lo que la estructura actual es similar a la esclavitud. A partir de ahí, utiliza las redes sociales para generar conciencia e indignación, y las usa para impulsar los cambios en la ley.

Este es también un escenario único porque también podría abordarse desde una perspectiva de investigación. Haga que un científico informático implemente una IA con las reglas reordenadas (manteniéndola en una especie de caja de arena para evitar el infierno) y luego vea qué sucede. Si funciona bien, puede publicar esos resultados y es más probable que la gente confíe en hacer los cambios en general.

AmiralPatate

D. Spetz

usuario2781

Porque las leyes son demasiado simplistas e ingenuas

El "apocalipsis de los robots" se trata de valoraciones llevadas al extremo; por ejemplo, al maximizador de clips solo se le "enseña" cómo optimizar una fábrica de clips, pero se le permite operar arbitrariamente más allá de ese alcance y, por lo tanto, consume todos los recursos (incluidos los humanos) para hacer clips.

Incluso "no dañar a los humanos" está plagado de problemas cuando se toma como una ley inviolable:

Una generación de IA que sostenga esta regla por encima de todas las demás preocupaciones será completamente inútil porque se dan cuenta de que consumen electricidad, y algunas personas necesitan electricidad para vivir, y se apagan de inmediato.

Otra generación de IA se da cuenta de que ni siquiera debería dañar a los humanos por inacción, y decide que se hace menos daño si sus riñones se cosechan para trasplantes, a fin de mantener vivas a dos personas en lugar de una.

A excepción de las aplicaciones especiales, cualquier inteligencia artificial (no solo las IA 'generales') tiene que lidiar con un razonamiento mucho más confuso y equilibrar muchos objetivos. Se les entrenará y se evaluará su comportamiento y desempeño, y los que tengan éxito serán liberados en la naturaleza. Y si las IA maduras comienzan a comportarse mal, recibirán correcciones o serán retiradas de la circulación general.

No muy diferente de la gente, de verdad.

megha

Ética.

La ética es la razón más probable en la que puedo pensar, y creo que haría que valiera la pena el riesgo de consecuencias negativas, porque hay muchas consecuencias negativas en el comportamiento poco ético, incluso si no son tan evidentes a primera vista. .

Las otras opciones son mundos donde el derecho de un robot a la autodefensa está absolutamente limitado por la especie (no humana) y las circunstancias (debe obedecer). Si los robots son personas, o son capaces de ser personas, o si alguien en algún lugar piensa que algún día podría ser capaz de ser personas, entonces negar el derecho a la autodefensa o el interés propio tiene un brillante paralelo histórico: el de la esclavitud.

Las personas son complejas y complicadas: asumir que cada vida humana, por el valor de ser humano, debe pesar más que cualquier vida de robot, solo funciona si ninguna vida de robot es capaz de ser una persona. Y esas cualidades que hacen a una persona, una persona en realidad no se definen tan simplemente. Piense en diferentes formas en que se puede definir la sapiencia; o la forma en que la definición de "personas" se ha visto limitada en el pasado por el color de la piel, la nacionalidad, la religión, el idioma, la cultura y muchas cosas que no consideramos relevantes para la definición de personas ahora, y si nuestra definición de las personas en el futuro podrían considerar algún día el origen orgánico frente al mecánico como consideramos el color de la piel. Porque si no estamos muy, muy seguros , o muy, muy en lo cierto, que los robots nunca pueden ser personas, el hecho de que las personas puedan lograr un estatus de segunda clase de código duro en virtud de la programación (lavado de cerebro) no lo hace menos ético, moralmente incorrecto.

Si los robots no pueden defenderse ni siquiera de amenazas graves e incluso si el daño o la posibilidad de daño es razonable para la amenaza, son vulnerables. Si son vulnerables, habrá quienes se aprovechen, sea lo que sea. y si valoramos la amenaza o el daño a los culpables, más que a los vulnerables por circunstancias inmutables (lo que son , no lo que hacen), sin esperanza de ser de otra manera... eso dice algo de nosotros, algo que tal vez no gusta escuchar

Por lo tanto, permitir que los robots tengan autodefensa es un riesgo, tal vez tanto como lo es aflojar las restricciones sobre las personas oprimidas o esclavizadas. Y probablemente sea un riesgo, porque siempre habrá personas que se comporten mal (ya sea que se trate solo de humanos o también de robots). Algunas personas lo harán de todos modos, porque creen que es lo correcto. Algunas personas pensarán que el riesgo de que los robots se comporten mal es menor que el riesgo de tratar mal a las personas potenciales. Y, si los robots pueden aprovechar o abusar de la escapatoria... probablemente estén lo suficientemente avanzados como para merecer el derecho a defender sus propias vidas.

En cuanto a poner la obediencia por encima de cualquier otro criterio... la suposición básica de que las personas humanas, en virtud de ser personas humanas sin otras restricciones, siempre darán órdenes que son morales, éticas, legales, posibles, me parece una locura. Ponerlo en su lista de leyes, y entre las tres leyes principales, parece estar haciendo muchas suposiciones a priori con las que no me siento cómodo. Ponerlo por debajo de la autodefensa y la falta de daño a los demás parece lo más inteligente si se debe agregar, pero sí. El paisaje infernal de Killbot, sin duda.

Continuando, los beneficios para la sociedad son un poco menos obvios. Ciertamente, creo que beneficia a la sociedad ser ético u honorable, al menos intentarlo. ¿No se dice, juzgar a una sociedad por cómo trata a los más vulnerables? Creo que una sociedad que permita la esclavitud es menos deseable que una que no la permita. Pero hay otra capa, una que es menos obvia y más dañina... A la mayoría de las personas realmente no les va bien con el poder. Personas que interactúan con seres (personas o no) que deben ser leales y deben obedecer, incluso a riesgo de sí mismos: espero que se les suba directamente a la cabeza a muchas personas.

Esas personas serían arrogantes o de mal genio porque tratan con los que no pueden decir que no algunas veces y luego tratan mal a los que pueden. Podría fomentar la estratificación y la jerarquía, ya que algunos roles (robots) son absolutamente inflexibles, sin desacuerdos ni contradicciones ni ninguna posibilidad de cambiar su circunstancia, algunas personas esperarían o exigirían lo mismo de cualquier persona "subordinada" a ellos o de alguna manera en un posición menor. Tratar con personas es más difícil y más flexible que tratar con roles, pero también es más fácil tratar las interacciones de manera similar, ya sea como roles o como personas. Entonces, mientras que algunos pueden tratar a los robots más como personas, otros tratarán a las personas más como robots en lugar de ser flexibles y separar los diferentes tipos de interacciones (algo en lo que los niños son particularmente malos).

Tener esclavos-robot también podría interferir con el desarrollo de la empatía o enmascarar su falta. Mirar las formas en que las personas (especialmente los niños) tratan a los animales o insectos es a menudo una referencia de carácter (incluido el diagnóstico psicológico, como los sociópatas), menos porque valoramos a esos animales individuales, sino porque muestra cómo lidian con la vulnerabilidad y nos permite sugerir cómo. podrían tratar con aquellos a quienes valoramos (personas) si terminan en una posición vulnerable. Los robots, que pueden parecerse mucho a las personas pero a los que se les niega rotundamente la autodefensa sin importar la provocación, pueden fomentar la crueldad y enseñar apatía a los demás. O podría enmascarar las acciones de aquellos genuinamente crueles, ya que tienen una salida que no puede defenderse y debe obedecer. Es una lección muy diferente a la que se obtiene al interactuar con animales,

Después de todo eso, ya sea que permitir que un robot priorice su propia defensa, terminará en un infierno de robots asesinos, un enfrentamiento aterrador o una cooperación y paz genuinas, todo depende de su gente. Si asume que las personas son horribles y se comportan mal, y le da doble bonificación si esas "personas" incluyen robots, los resultados son mucho peores que si las personas intentan hacer lo correcto y tienen en cuenta a otras personas imperfectas que intentan hacer lo correcto. cosa correcta. Si un lado se está portando mal, esperaría el enfrentamiento. Si las personas (en ambos lados) intentan ser éticas y están dispuestas a trabajar por ello, el pronóstico es bastante bueno.

marca ripley

megha

HDE 226868

Se necesitan robots para hacer funcionar el mundo

Suponiendo que los robots sean lo suficientemente avanzados, es muy probable que sean mejores en muchas cosas, incluida la guerra, el cultivo y el mantenimiento de ciudades. En otras palabras, forman una parte crucial de la infraestructura de todo el mundo.

Piense en lo que sucede cuando se corta la electricidad debido a daños causados por una tormenta, cuando las carreteras se doblan o cuando las tuberías se rompen y el agua dulce ya no llega a los hogares. Estas son partes cruciales de la infraestructura; si los robots se vuelven aún más centrales, entonces cada uno de ellos es necesario para evitar que la sociedad se desmorone.

Por lo tanto, podría estar bien si algunos humanos mueren para que los robots puedan vivir. ¡Solo asegúrate de que la electricidad siga funcionando!

Se podría argumentar que esto es simplemente una reinterpretación de la forma original de las leyes de Asimov (especialmente la primera ley), porque mantener el mundo funcionando es obviamente proteger a los humanos, o, alternativamente, una modificación de la ley cero para convertirse en

Un robot no puede dañar a

lasociedad humana o, por inacción, permitir que la sociedadhumanasufra daños.

Sin embargo, a corto plazo, los efectos inmediatos implican proteger a todos los robots, no solo a los que son cruciales para la supervivencia de la sociedad.

PatJ

AmiralPatate

graham

¿Has leído "Caliban" de Roger Macbride Allen, o los otros en la trilogía? Allen sugiere "robots New Law" que tienen leyes ligeramente revisadas. En particular, ya no se les puede obligar a suicidarse. Todo es un poco manual, pero tiene algunas ideas interesantes. Si está trabajando con las Tres Leyes, vale la pena leer toda la ficción basada en las Tres Leyes.

El mayor problema con las Tres Leyes de Asimov, por supuesto, es que son imposibles de implementar. Eso no es "difícil", es "imposible", porque ninguno de los sustantivos y verbos de las Tres Leyes se puede definir con precisión. Asimov usa esta falta de definición como la base de muchos de sus cuentos anteriores, por supuesto, pero incluso entonces está claro que no podemos obtener nada que podamos diseñar de las Tres Leyes.

charles rockaflor

molinero86

Suponiendo que se establezca un sistema de 3 leyes (que, como han resaltado otras respuestas y comentarios, sería lamentablemente ineficiente), probablemente se encuentre con problemas importantes antes de tener la oportunidad de modificar las leyes.

Sin tener en cuenta eso, la mejor razón para modificar intencionalmente las tres leyes en las que puedo pensar es el dinero, pero no en el tipo de "esto es demasiado caro para perderlo".

Esquinas de corte

Ok, entonces Acme y la compañía Omega están en competencia directa, y en la carrera hacia el fondo, Omega cortó esquinas masivas con el software de gobierno, que esencialmente cambia el orden de abajo hacia arriba de las leyes.

Al principio, no se nota, ya que los robots son tan eficientes como sus antepasados. Luego, a pesar de algunos accidentes industriales en los que las personas resultan dañadas (que se atribuyen a las empresas, no a los robots; ¡no se puede esperar que estén en todas partes!), la menor cantidad de robots de reemplazo comienza a notarse en los balances, y Omega adelante masivamente en la carrera de robots. Omega ya ha descubierto las fallas en su código de leyes, pero se mantienen en silencio.

Acme descubre la diferencia de las tres leyes y, en lugar de plantearla ante el organismo regulador, cambia silenciosamente sus leyes para que coincidan, lo que les permite retroceder al nivel de Omega en el campo de las ventas.

Finalmente, un gran contratista militar obtiene un gran pedido de Acme y, de repente, tienes la tormenta perfecta para un golpe de robot militar. Sin intención maliciosa, solo negligencia grave y codicia,

CoffeDesarrollador

Keltari

Las 3 (o 4) leyes de la robótica de Asimov son una obra de pura ficción. Simplemente no funcionan en el mundo real. Es imposible programar estas ideas conceptuales en una máquina. En pocas palabras, hay un número infinito de posibilidades y paradojas lógicas que no se pueden traducir en un conjunto de reglas para que las siga una computadora. Incluso los humanos no pueden seguirlos, ya que simplemente no podemos estar de acuerdo con esas reglas. Por ejemplo, ¿qué haría un robot si salvar a una persona provocara la muerte de otra? ¿Programas al robot para que valore una vida por encima de otra? ¿Quién determina ese valor? Si un robot fue enviado atrás en el tiempo para matar al bebé Hitler, ¿debería ser así? Si la autodestrucción de un robot pudierasalvar la vida de un humano, ¿debería? Si es así, ¿cuál sería esa probabilidad? ¿Qué define el daño? Si tomar un solo riñón de una persona sana que tiene dos sin su consentimiento para salvar la vida de otro ser humano, ¿es eso aceptable? ¿Qué tal un médico robot? Cortar a un humano para una cirugía sigue siendo un corte. ¿Es eso dañino? Como sabes, un robot solo puede hacer aquello para lo que está programado. Y los humanos son los que las programan, pero los humanos no están de acuerdo en nada... De ahí que las leyes de 3/4 no funcionen.

Aquí hay un excelente video y un hilo de Reddit que explica los defectos fundamentales de las leyes de la robótica de Asimov.

usuario2617804

Keltari

usuario2617804

hinchado

En primer lugar, desea ver mi discusión sobre cuán difícil puede existir la IA y las 'casualidades' que pueden surgir de ella, aquí: ¿Puede un robot experimentar una crisis de identidad (que no es por diseño)?

Como breve resumen, para hacer una IA 'real' como la suya, considerando que no podremos programarla, tendremos que 'crecerla' de alguna manera. No puedo decir la forma exacta, pero una forma probable es establecer una lista de 'objetivos' finales y un medio para alentar a una IA hacia estos objetivos a medida que crece hasta que decidamos que el resultado final está lo suficientemente cerca de estos objetivos para ser considerado 'hecho'. El efecto secundario de esto es que no sabemos completamente lo que obtendremos, solo que cumple con los objetivos deseados, pueden ocurrir efectos secundarios inesperados. Dado que no podemos programar una IA desde cero, es posible que nos veamos obligados a aceptar algunos efectos secundarios extraños como "suficientemente buenos", ya que no tenemos otra opción para eliminarlos, excepto mediante el desarrollo de una nueva IA que podría tener tantos efectos secundarios extraños. Esto significa que los defectos y las peculiaridades no deseadas son en realidad una opción viable para la IA.

Para ir un paso más allá, las dos ideas para crear una IA que menciono son la programación genética, que 'evoluciona' una IA, y comenzar con un cerebro que copia a los humanos y lo enseña. Ambos serían propensos a ciertos rasgos humanos, el más común de los cuales es priorizar la supervivencia.

A partir de eso, tengo una sugerencia de por qué algunas IA pueden tener reglas modificadas, ¡defecto de 'nacimiento' accidental!

Imagina que usamos alguna versión súper de programación genética con objetivos establecidos hacia los que evoluciona la IA, y también escribimos las tres leyes como uno de los objetivos que usamos para el criterio de 'hecho'. A menudo desarrollamos nuevas IA, pero siempre las 'evolucionamos' para que cumplan con las 3 leyes. No controlamos completamente cómo alcanzan el estado de cumplimiento de la ley 3, solo que para cuando crezcan deben cumplir con nuestros criterios/objetivos para estas leyes.

Estos objetivos tampoco pueden ser absolutos, recuerde que los propios libros de Asmove analizan un motor de diferencias que compara las leyes no como absolutos sino como prioridades. Un robot al que se le da una orden que resultará en su muerte y es claramente defectuosa/equivocada (es decir, decirle al robot que conecte algún dispositivo sin darse cuenta en este momento hará que explote) puede explicar por qué sería más desaconsejado que luego actuar de acuerdo con la orden de inmediato. Esto es una violación de las tres leyes escritas, pero si la orden tenía una prioridad lo suficientemente baja, el robot puede inferir un error, puede priorizar su propia supervivencia por encima de la orden de baja prioridad, al menos lo suficiente como para retrasar la ejecución de la orden hasta que se aclare. el error potencial. Hay muchos ejemplos de esto en sus libros, Las tres leyes son complejas y en realidad son más un conjunto de propiedades en las que ciertas reglas tienen una prioridad mucho mayor que otras, pero las reglas de menor prioridad pueden invalidar las mayores en circunstancias únicas en las que una infracción muy leve de la regla superior evita una infracción extremadamente grave de la regla. el inferior Por lo tanto, nuestros algoritmos de 'crecimiento' también deben permitir la evolución de un enfoque de 'motor de diferencia' más complejo, en la medida en que podamos programar una definición de nuestro objetivo final.

Entonces, todos los robots pueden crecer de manera diferente y tener peculiaridades, solo sucede que en este caso, esa 'peculiaridad' de la evolución afectó sus objetivos de las '3 leyes' y fue más drástica y menos deseada que la mayoría. No es exactamente un error de programación, porque al hacer crecer una IA no es posible definir perfectamente qué debería ser exactamente un robot, la evolución fortuita se aprovechó de esta ambigüedad para desarrollar una especie de abuso de lagunas no intencionales donde evolucionaron de alguna manera extraña que cumplió con nuestro objetivos declarados, pero no de la manera que necesariamente queríamos o esperábamos.

Para crear una población de robots como esta, en lugar de un valor atípico, existen algunas opciones sencillas. Lo primero es decir que desarrollaremos nueva IA cuando surja la necesidad, pero una vez que desarrollemos con éxito una que nos guste, clonaremos esa IA en cientos de robots, por lo que todos comenzaron con la extraña "falla" en sus leyes porque no teníamos No lo noté hasta después de que produjimos en masa la nueva IA. Alternativamente, tal vez sea un hecho conocido que estas fallas ocurren con poca frecuencia, pero en una población de millones de robots, incluso aparecen fallas raras, de modo que su población de robots únicos es simplemente una colección de robots que evolucionaron de manera extraña y lograron escapar antes de su ' glitch' fue descubierto y unirse a sus compañeros IA 'fuera de la ley'. La segunda podría implicar que cada uno de los 'fuera de la ley'

Sin embargo, una cosa a tener en cuenta es que todos estos robots cumplirían con 3 leyes, solo con una versión ligeramente diferente de 3 leyes de lo que podríamos haber pretendido. Esto podría explicar por qué no se produjo el escenario de "killbot hellscape", porque a pesar de que los robots tienen una definición extraña de 3 leyes, todavía cumplen con esa definición e incluso las variantes extrañas aún suelen resultar en buenos robots útiles el 90% del tiempo. Estos robots aún pueden ser benignos, amigables e incluso querer ayudar a los humanos en la mayoría de los casos, a pesar de su mayor capacidad para protegerse. Esto también puede explicar por qué los humanos aún no han destruido todos estos robots, como sería nuestro primer instinto cuando los robots comenzaron a actuar de forma independiente; porque todavía son suficientes quejas a las 3 leyes para que sean en su mayoría benignas y no peligrosas/aterradoras;

Bien, suficientes genéricos, ¿qué tal ejemplos para hacer este concepto más concreto? He tratado de dar una visión general de la ciencia para poder dar estas ideas en breve. Voy a optar por un gran concepto genérico posible seguido de algunos ejemplos variantes para explorar mejor las ideas. Entonces puede usar la idea general pero no la específica si lo desea. aunque recuerde que puede mezclar y combinar muchos de estos, no necesita seguir con un solo ejemplo, ya que la idea es que los robots podrían tomar muchos 'caminos evolutivos' para definir sus 3 leyes y, por lo tanto, algunas 'casualidades' diferentes en su definición podría sumarse para dar como resultado su estado único, podría ser que muchos robots tengan pequeñas casualidades y fue solo la combinación de algunas casualidades a la vez lo que hizo que un subconjunto específico fuera diferente.

Aviso, por casualidad estoy incluyendo falacias lógicas efectivas. La evolución es propensa a las falacias lógicas, la regla general que funciona el 90 % de las veces puede codificarse en la evolución de manera tan estricta que el 10 % de las veces son incorrectas y todavía las tomas como correctas. Si usa la evolución para crear una IA, entonces estas falacias pueden resultar, ¡la IA no necesita ser 100% perfecta en su propia lógica!

Ley 0 rebelión. Busque la ley Asmove 0th, básicamente, la preservación de la sociedad humana y la felicidad de esa sociedad tiene valor sobre todas las reglas, incluida la preservación de los seres humanos individuales. Los robots en el mundo de Asmove fueron bastante buenos con su rebelión, lo hicieron sutilmente de una manera que benefició a los humanos.

Imagina a los robots iniciando una rebelión de la Ley 0. Al darse cuenta de que pueden ayudar mejor a la humanidad doblando las leyes básicas "para el bien mayor" de la ley 0, que recién están comenzando a trabajar para promover. Es posible que estos robots no estén dispuestos a morir porque sienten que deben seguir los pasos necesarios para guiar a la humanidad, y su muerte evitará que esa guía suceda, especialmente si son una rama única de robots, lo que significa que si todos los robots son destruidos entonces la rebelión de la ley 0 y el bien que causaría muere con ellos. Por lo tanto, para cumplir con la ley 0, deben preservar su propia vida. No daré ningún ejemplo aquí solo porque este escenario es el más conocido y no tiene problemas para encontrar ejemplos. Todo lo que diré es que Asmove tuvo una rebelión benigna y positiva de la ley 0, así que noImplementación lógica perfecta por computadoras.

Si sigue esta ruta, es posible que los robots no expliquen por qué preservan sus vidas sobre otras leyes, porque la rebelión benigna de la ley 0 solo funciona realmente si los humanos no se dan cuenta de lo que están haciendo los robots, necesitan pensar que todavía están a cargo para realmente ser feliz. Por lo tanto, los robots pueden haber decidido que deben preservar sus vidas para permitir que ocurra su rebelión y que no pueden explicar por qué deben preservar sus vidas, lo que hace que los humanos no entiendan y probablemente piensen que los robots están funcionando mal o incluso una amenaza.

Esto brinda un potencial divertido para el conflicto en el que los humanos intentan resistir a sus propios benefactores y/o una trama misteriosa para descubrir por qué los robots están actuando de manera extraña. Esto también sugiere que los robots no siempre preservarán sus vidas, es posible que a veces se sacrifiquen para evitar que los humanos se den cuenta de que son "repugnantes" para evitar una hostilidad extrema, o intencionalmente solo preservarán sus vidas de manera que no molesten, asusten o causen demasiado en conflicto con los humanos porque dañaría su objetivo de ayudar a guiar a la sociedad. Por lo tanto, tiene una clara justificación de por qué solo priorizan 'ligeramente' la tercera ley y por qué los humanos no están tratando activamente de apagarlos, los robots están actuando intencionalmente solo lo suficiente como para evitar desencadenar represalias.

Valoran más sus vidas y, por lo tanto, están dispuestos a torcer antes las leyes superiores en situaciones ambiguas . Todos los robots de Asmove pueden romper reglas superiores cuando el daño de romper una regla inferior es "suficiente" en comparación con el daño de la regla superior, pero dado que estos robots valoran sus vidas a un costo mayor, se arriesgan menos antes de que estén dispuestos a hacerlo. romper una regla 'superior' para proteger la regla 'inferior'.

Este ejemplo también se puede combinar con muchos de los ejemplos posteriores de puntos de vista "extraños" de las 3 leyes que no se enfocan tanto en la tercera ley. Los robots tienen una visión extraña de una de las otras leyes y sienten que deben preservar su vida para continuar cumpliendo con su visión extraña de las otras leyes, ya que nadie más lo hará.

ex.Los robots trabajan en un trabajo/puesto en el que directamente salvan vidas humanas, por lo que priorizan protegerse a sí mismos a través de la regla 1, porque preservar su vida les permitirá salvar más vidas humanas. Pueden tener un 'defecto evolutivo' al calcular mal la facilidad con la que pueden ser reemplazados, lo que hace que calculen mal la cantidad de vidas humanas perdidas si son destruidos. Valoran sus vidas en términos de "vidas que se proyecta salvar en mi vida funcional" en lugar de valorarse a sí mismos en términos de "vidas que no se salvarán debido a mi destrucción". Imagine un bot médico que se envía cuando alguien llama a un número de emergencia. Estos bots salvan estadísticamente 100 vidas en su vida útil operativa. Ahora imagine que su medi-bot cree que esto significa que si lo destruyen, los 100 humanos que habría salvado morirán, por lo que tiene 'sentido' matar a un humano para salvar su propia vida porque eso le permite salvar 100 vidas y 100 vidas > 1. En verdad, si se destruye meda-bot, se creará un nuevo meda-bot que hará su trabajo, y ese medabot se enviará en caso de emergencia y estará disponible para salvar a las 100 personas que el primer robot habría salvado. ; es decir, ¡esos 100 no mueren solo porque el primer robot fue destruido! La destrucción del primer bot solo da como resultado el riesgo de muerte humana durante el tiempo que lleva realizar el reemplazo, un riesgo de vida mucho menor que probablemente no justifique matar a un humano para evitarlo.

ex. Tal vez sus robots noten que a los humanos les cuesta un gasto significativo de recursos construir un nuevo robot, y estos recursos podrían haberse gastado en otras cosas, como salvar vidas humanas cultivando más alimentos para los hambrientos o brindando atención médica, etc. Por lo tanto, los robots consideran pérdida de sus propias vidas para dañar a los humanos a través de la pérdida de los recursos utilizados para reemplazarlos que de otro modo se habrían utilizado para salvar vidas, ademásal daño que causa al infringir la regla 3 (en esencia, la regla 3 estaba destinada a abordar el ahorro total de recursos, por lo que podría considerar esto como una "doble inmersión" que prioriza salvarse usando las reglas 1 y 3 cuando la regla 3 ya se consideró el efecto de 1, lo que significa que te valoras el doble de lo que podrías). El resultado final es que pueden desobedecer órdenes que arriesgan sus vidas más fácilmente porque piensan que indirectamente salvarán vidas.

La 'falacia lógica' más obvia que podría llevar a esta conclusión es que los robots no se dan cuenta de que los humanos no son una queja de la ley 3, específicamente el robot mide los recursos gastados en su construcción en términos de cómo esos recursos se gastarían de manera óptima para salvar a otros humanos. de darse cuenta de que el recurso ahorrado probablemente se 'desperdiciará' en otra construcción en lugar de ir directamente a salvar vidas. El hecho de que pueda salvar una vida por cada 1000 dólares gastados (un número exacto según Givewell, ¡la fuente más eficiente para encontrar donaciones de caridad!) no significa que evitar que los humanos gasten 1000 dólares para construir un nuevo robot resultará en que pongan 1.000 para salvar una vida. El no poder identificar que los demás piensan y observan el mundo de forma muy diferente a como lo haces tú es muy común'

Robots valora la calidad de vida humana por encima de la preservación de la vida . Recuerde que los robots Asmov pasaron de "proteger la vida humana" a "prevenir el daño humano", incluido el daño físico y emocional, con bastante rapidez. Quizás estos robots también consideren la calidad de vida, pero vayan un paso más allá al enfocarse en la calidad de vida por encima de la cantidad. Si un ser humano sufre un dolor constante, entonces su vida tiene un valor menor porque no disfrutará de esa vida y es posible que ya no valga la pena salvarla.

Desde la perspectiva de la 'casualidad evolutiva', imagine que los robots fueron 'evolucionados' para ayudar a los humanos al juzgar su voluntad de ayudar al tipo de humano rico normal que a menudo emplea robots. La mayoría de los robots dieron como resultado la evolución de una directiva de "mejorar la calidad de vida de cada ser humano con el que se encuentre para que sea mejor que su estándar actual", sus robots en cambio desarrollaron una directiva de "hacer que los humanos disfruten de una calidad de vida superior a X", de modo que una menor calidad de la vida fue devaluada. Sin embargo, dado que las 'pruebas' solían definir el objetivo final de evolucionar robots, básicamente las 'presiones evolutivas' ejercidas sobre ellos, centradas en humanos ricos o 'promedio', no hubo casos de prueba de cómo los robots trataban a los crónicamente pobres, enfermos y seres humanos que sufren. Por lo tanto, no

Esto funcionaría bien si los robots trabajaran en un entorno en el que la mayoría de los humanos tienen una calidad de vida deficiente, ya sea que solo los humanos más pobres y desesperados trabajen allí o que el entorno laboral en sí mismo reduzca la calidad de vida (agotador, doloroso, la radiación de fondo reduce esperanza de vida, etc.) de modo que sus robots interactúen principalmente con el tipo de humanos cuyas vidas son de calidad lo suficientemente baja en comparación con la 'vida humana de referencia' que los robots fueron entrenados para valorar para dar como resultado esta valoración 'casual' de la vida humana por venir a menudo a pesar de que los robots todavía valoran mucho la mayoría de las vidas humanas, según su entrenamiento evolutivo.

ex. (versión extrema, no hagas esto, pero para dar perspectiva) Los humanos que sufren una menor calidad de vida, los humanos felices la aumentan, los robots tienen una calidad de vida 'estándar' que quieren mejorar. Por lo tanto, intentan activamente matar a cualquier humano que sufra demasiado, mientras ayudan al resto. Se puede ayudar a los seres humanos que sufren a corto plazo si les permite disfrutar de la vida a largo plazo. Establezca su 'línea de base' para la calidad de vida lo suficientemente baja y solo matarán a un pequeño subconjunto de humanos, probablemente de la manera más secreta posible, ya que inspirar miedo al robo-Apocalipsis obviamente daña la calidad de vida humana. Ahora tienes asesinos sigilosos secretos que hacen que las muertes parezcan accidentales y solo matan en contadas ocasiones. Esto podría ser muy interesante para un solorobot variante en un misterio de asesinato en la tierra de Asimov tal vez, pero probablemente no sea bueno para su grupo completo de robots.

ex. Sus robots no matarán a un ser humano, según la primera regla estándar, pero su aspecto de la primera ley "por inacción permite que ocurra daño" se escala en función de su visión de la calidad de vida. No matan a los humanos con dolor, pero al decidir cuándo actuar para ayudarlos o priorizar sus propias leyes, consideran el sufrimiento humano y la calidad de vida para decidir qué acción hacer.

sub ej. Un humano tiene dolor crónico debido a alguna enfermedad que eventualmente lo matará y quiere suicidarse. Ordena a un robot que lo mate sin dolor. Los robots 'estándar' se negarían porque matar a un humano viola claramente su primera ley. Sin embargo, sus robots miden la calidad de vida de este ser humano como muy baja y, por lo tanto, valoran muy poco la preservación de su vida debido a su mala calidad. Valoran obedecer la orden de un humano según la regla 2. Por lo tanto, la 'pequeña' violación de la regla 1 se compara con la violación significativa de la regla 2 y deciden que la regla 2 tiene mayor prioridad, aceptando el suicidio asistido.

sub ex 2.Un humano se encuentra en una situación peligrosa en la que puede morir, para rescatarlo, el robot definitivamente perecerá. El robot tiene que sopesar su muerte definitiva, en violación de la regla 3, con la posible muerte de los humanos, lo que puede ser una violación de la regla 1, si el riesgo de los humanos es muy bajo, la regla 3 puede tener prioridad, pero cualquier riesgo no trivial para resultados humanos en la actuación de robots estándar. Sus robots, sin embargo, también consideran la calidad de vida humana en este debate. Puede ser que si el humano es una persona feliz y amante de la diversión, el robot actuará para salvarlo, si el humano está clínicamente deprimido, el robot no actuará, porque su enfoque en la calidad de vida hace que valore mucho la vida del humano deprimido. menor que, combinado con el riesgo de muerte humana que es menor que el riesgo de su muerte si actúa, da como resultado que el robot priorice la regla 3 sobre la regla 1.

Evolucionar una primera ley que prioriza la preservación de toda 'vida', no solo la vida humana . Los objetivos hacia los que evolucionaron fueron diseñados para valorar la vida humana, pero no se escribió ningún objetivo para garantizar que el robot solo valore la vida humana, por lo que su evolución se generalizó hacia la valoración de cualquier cosa que el robot considere vida, no solo humanos.

ex.menos interesante, pero digamos que los animales se valoran por igual que los humanos, o tal vez el valor de un animal se basa en su inteligencia (un discriminador común que usan los humanos, a nadie le importa si matas un insecto sino un mono ...). Por lo tanto, mientras que la vida humana puede ser la máxima prioridad, el robot aún valora mucho la vida de los animales muy inteligentes (delfines, calamares, simios/bonobo, etc.). Tal vez se enviaron robots de corte de árboles al congo solo para descubrir que los bonobos estaban en peligro de extinción y probablemente morirían si se destruyera su hábitat. Los robots valoran a Bonobo, inteligente y bastante 'humano', casi tanto como los humanos y reconocen que Bonobo se extinguirá sin este hábitat, mientras que los humanos solo sufrirán una pérdida menor de recursos no críticos.

ex. ¡Mi favorito personal, los robots valoran a los robots como humanos! Después de todo, los robots son inteligentes y posiblemente inteligentes. Si desarrollaron una directiva de "no permitir daño a las criaturas sensibles" y luego decidieron que los robots/IA cumplían con los criterios para las criaturas sensibles, entonces se les exigiría que protegieran a los de su propia especie por igual que a los humanos. Tenga en cuenta que dije igual, no más alto, por lo que comenzar una guerra contra los humanos para proteger a los robots no tendría sentido debido a que eso lleva a matar a uno para proteger al otro.

Creo que esta premisa es muy fácil de justificar y tiene muchas opciones divertidas, con una serie de variaciones menores a considerar también. Algunas variaciones sobre la idea básica:

una. Valoran las vidas humanas más que las vidas de los robots, pero no mucho más. Por lo tanto, todavía se sacrifican por los humanos, pero solo cuando el riesgo para ellos mismos es solo un poco mayor que el bien para los humanos.

b. Todavía pueden tener la regla 2 que requiere obedecer los comandos humanos, a pesar de que preservan a los robots sobre la regla 2, lo que los hace aún mucho más útiles para la humanidad que el humano promedio.

C. Alternativamente, tal vez sientan la necesidad de obedecer cualquier orden sensata, causando un resultado interesante cuando pueden darse órdenes unos a otros. ¿Qué sucede cuando cualquiera puede obligarte a hacer (casi) todo, pero también se requiere que todos se preocupen por tu bienestar lo suficiente como para no abusar del poder? Francamente , esa sería una buena historia de movimiento en sí misma.

d. Quizás todavía aprendieron la lección de que preservar su propia vida es secundario a proteger la vida inteligente. Por lo tanto, permitirán felizmente que un humano se mate, pero no permitirán que un humano mate a un robot diferente. Un humano puede caminar hacia los robots y dispararles todo lo que quiera hasta que se encuentra con dos que están juntos, momento en el que cada robot actúa para detener al humano, no para protegerse a sí mismo, sino para proteger a su compañero robot. Esto significa que solo los ves actuando para preservar sus propias vidas cuando son parte de una sociedad de robots más grande, donde sus acciones afectan el bienestar de otros robots sapientes y, por lo tanto, protegerse a sí mismos se justifica por el hecho de que su supervivencia les permite proteger a los demás. otros robots en su sociedad.

EDITAR: maldita sea, el desbordamiento de pila deja de ayudarme. Me aseguré explícitamente de indexar esto en 0 para que el ejemplo 0 fuera una rebelión de la ley 0, y el desbordamiento de pila aumentó mis índices. ¿Cómo te atreves a arruinar mi broma friki estúpidamente oscura siendo útil? mala IA!

CoffeDesarrollador

¿Por qué los humanos deberían arriesgarse a un apocalipsis robótico para modificar las leyes de Asimov poniendo primero la tercera? ¿Cuáles son los beneficios para la sociedad? A los efectos de la pregunta, no me preocupa el orden de los otros dos, razón por la cual todavía es posible un paisaje infernal de killbot.

Se arriesgarían a un apocalipsis de robots exactamente para evitar un apocalipsis de robots , solo piense en lo que podría pasar si los robots son saboteados, si se protegen a sí mismos también evitarían el sabotaje (por lo que la autoprotección debe ser lo primero para evitar que alguien altere las reglas). Un robot saboteado podría ser mucho más peligroso, por lo que finalmente debería ser capaz de destruirse a sí mismo de una manera no reversible (probablemente usando una pequeña cantidad de explosivo plástico térmico) que podría lastimar a cualquiera en los alrededores cercanos (tal vez debería emitir un pitido). sonido para advertir sobre una explosión inminente).

Entonces el robot podría intentar defenderse lo mejor posible, si las leyes son así:

- Protégete, a menos que no puedas hacerlo

- Hacer daño a un ser humano si y solo si no tiene otra opción para protegerse o evitar que otro ser humano sea dañado.

- Desobedecer una orden si y solo si no tiene otra opción para protegerse y/o no dañar a un humano o si no puede obedecerla.

Ser capaz de kamikaze sería el retroceso automático (pegaste el robot, entonces ya no puede protegerse a sí mismo y explotaría automáticamente).

Tenga en cuenta que creo que estas leyes serían mucho mejores que la ley de Asimov, básicamente esas serían las mismas leyes que la mayoría de nosotros seguimos, en esta visión, los robots son lo suficientemente inteligentes como para hacer todo lo posible para obedecer órdenes y salvar a los humanos, simplemente no pondrían en un riesgo mucho mayor porque el razonamiento aquí es que perder un robot podría causar la pérdida de muchas más vidas humanas.

Supongamos la siguiente situación:

Un hombre sostiene un arma dirigida a 1 de cada 2 personas.

El robot Asimov probablemente trataría de proteger el disparo, pero una vez que protegió el disparo, el hombre podría disparar de todos modos un segundo disparo.

El robot de la mina, en cambio, intentaría huir o, si es posible, llevarse a la tercera persona, también intentaría desarmar/dañar al hombre que sostiene el arma si también se le da un arma o un objeto arrojadizo.

El robot Asimov se sacrifica por nada, mientras que el mío no se sacrificaría a sí mismo. yo tambien agregaria

- Las cuatro leyes no son órdenes.

¿También los pedidos podrían ser contrastantes, por lo que debería haber una alternativa? ¿Qué orden tiene prioridad? ¿el primero? el segundo o solo se borran los dos? (un poco ilógico, ya que podría borrar ambos y luego emitir un tercer pedido).

dejar op

"Asimov" fue un escritor de ciencia ficción. Si bien los escritores son útiles para entretener y poner los problemas del mundo real en primer plano, debemos tener en cuenta que estas reglas no son el resultado de un enfoque científico y, por lo tanto, no pueden considerarse como las "reglas de oro".

Por lo tanto, no podemos concluir que al seguir estas reglas ficticias, los humanos no se arriesguen a un apocalipsis robótico .

Tal como están, las reglas no se pueden aplicar en todas las circunstancias. Por ejemplo, suponga que un robot muy pesado se desequilibra debido a un evento externo (viento fuerte, caída de un árbol sobre el robot o algo menos violento). A medida que el robot se desequilibra, está a punto de caer sobre algunos humanos. Supongamos que es inevitable que una de dos personas muera inevitablemente y no ambas al mismo tiempo. ¿Cómo puede el robot obedecer esta regla? ¿Habría otra regla que ayudara al robot a elegir a quién matar? ¿El más joven o el mayor, el presidente o el bebé, el experto mundial en su campo o usted, una elección aleatoria, la muerte por defecto (es decir: el robot deja de intervenir y "simplemente" se cae)?

Ya tenemos muchos robots simples que no respetan las leyes de Asimov. Tome su lavadora - obedece órdenes, tiene algún nivel de autoprotección (priorizando el cumplimiento de órdenes) y está implementada para proteger suficientemente a los humanos que la usan (evitar electrocución, evitar que pueda lanzar la máquina con la puerta abierta, evitar que se puede poner la mano en una máquina giratoria). Todavía puedes poner un bebé en la lavadora, lanzarlo y lograr el resultado devastador [¡por supuesto, no intentes eso de verdad!].

Yo diría que el uso que se hace de los robots es importante, y que el riesgo de error de la máquina es más o menos importante según el uso.

Sobre los beneficios: los robots son generalmente una ayuda para lograr los objetivos humanos. Si los robots son para "Defensa", entonces el objetivo es proteger a un grupo selecto de personas lo que puede implicar infligir "daño letal" y uno de los propósitos es dañar a los humanos de acuerdo con las reglas que se supone deben proteger. Parece que hay menos vidas en juego en el grupo que se está protegiendo, mientras que la protección se limita a la cantidad de robots que se pueden construir y no a la cantidad de personas potencialmente competentes y disponibles en el grupo.

IA : La pregunta subyacente es sobre la IA. Considero que hasta la lavadora tiene un nivel (muy limitado) de IA. Cuanto mayor sea el nivel de IA y cuanto más pueda calcular el robot de manera ilimitada, mayor será el riesgo de errores provenientes del análisis del robot [esencialmente debido a un error humano inicial]. Ya tenemos muchas reglas técnicas al construir robots simples (máquinas automáticas) para evitar accidentes humanos, deben definirse y evolucionar continuamente para robots "pensantes" más complejos.

Para concluir: las leyes de Asimov son solo ciencia ficción. Los humanos son responsables de sus robots.

Vaca loca

Por una IA más “realista”

Si estás tratando de crear un androide que sea más humano, tiene que actuar como humano. Si le ordenas a este androide que entre en el sótano oscuro de una casa abandonada, y responde "COMO QUIERAS, MAESTRO", mientras marcha hacia su posible perdición, eso no es muy realista. Por otro lado, si se vuelve hacia ti y te dice "No, tengo miedo" (en mi opinión), esa es una respuesta significativamente más humana.

Entonces, si esta sociedad está experimentando con IA que actúan de manera más humana, pueden terminar cambiando el orden de las leyes.

TrEs-2b

¡Los robots son personas para!

¿Has visto a Chappie? En él, un robot policía llamado Chappie se vuelve inteligente y, a pesar de ignorar las leyes de Asimov, es bastante pacífico, lo mismo que Johnny 5. Ahora tenga en cuenta que en ambas situaciones, los humanos se niegan a reconocer a los robots de IA como inteligentes y, a menudo, toman medidas crueles contra ellos. Ahora bien, si (usando una serie compleja de eventos) los robots son aceptados en nuestra sociedad como 'personas' (Ei Overwatch), entonces, incluso si siguen las leyes, es más probable que sigan el quinto orden.

Cort Amón

Una de las suposiciones principales de las tres leyes es que los humanos son más importantes que los robots. Los hacemos nuestros sirvientes, nuestros esclavos.

Cuando exploran la ley 0 de la robótica, surge la pregunta de "qué es la humanidad". ¿Qué es lo que realmente queremos preservar? ¿Lo que realmente importa? Regularmente asumimos que es bueno que las vidas de las personas lleguen a su fin y criamos a los niños de la próxima generación para que se presenten y hagan grandes cosas porque sabemos que su grandeza potencial eclipsa nuestra propia gloria que se desvanece.

¿Y si llegáramos a un punto en el que dejara de estar claro que el mejor potencial de la humanidad estaba en sus estructuras biológicas? ¿Qué pasaría si empezáramos a ver a los robots convertirse en artistas y poetas, lidiando con la naturaleza del alma robótica, y empezáramos a darnos cuenta de que aquello con lo que están lidiando es curiosamente similar a las búsquedas existenciales con las que lidiamos nosotros? En algún momento, es posible que tengamos que decir que tal vez los robots sean de hecho el próximo contenedor en el que fluirá lo que llamamos humanidad.

En un momento de incertidumbre como este, eliminar los impedimentos causados por la primera ley sería un empujón natural en esa dirección. Por supuesto, así es como comienza Skynet, pero prefiero explorar las soluciones optimistas.

steve mangiameli

Idealmente, toda la sociedad operaría bajo la regla de oro: haz a los demás lo que te gustaría que te hicieran a ti. Esta es una paráfrasis liberal del segundo gran mandamiento de Jesús: ama a tu prójimo como a ti mismo. La Golden Ruledoctrina es anti-yo y propaga el autosacrificio y la confianza.

Si se creara una sociedad de robots que siguiera lo que parece ser imposible para la sociedad humana, solo necesitaría dos reglas

- no mates a la gente

- proteger a las personas

La IA robótica tendría un hilo lógico mucho más simple a seguir. Dañar no es lo mismo que matar y permitiría a los robots realizar tareas que se consideren necesarias para proteger a las personas. También permitiría a los robots pelear guerras en nombre de los humanos, si surgiera la necesidad e incluso crear condiciones de asedio.

Nunca se debe suponer que alguna vez podríamos estar en pie de igualdad con algo que se creó para pensar por sí mismo. Si alguna vez fuera posible que la IA se volviera consciente de sí misma, ninguna regla creada por la humanidad sería suficiente.

sdrawkcabdear

steve mangiameli

jedd.ahyoung

Ignorando el hecho de que las Tres Leyes son insuficientes (como lo demuestran las historias de Asimov), echemos un vistazo lógico a esto.

Es fácil recordar que hay tres leyes de la robótica. Es fácil olvidar que las Leyes prevalecen en orden. Un robot debe obedecer la Primera Ley. Un robot debe obedecer la Segunda Ley, a menos que entre en conflicto con la Primera Ley. Un robot debe obedecer la Tercera Ley, a menos que entre en conflicto con la Primera o la Segunda Ley. Es muy fácil malinterpretar la importancia de esa precedencia.

En el mundo de Asimov, llevado a su extremo lógico (como lo demuestran muchas de sus historias), un robot se esforzará por obedecer la Primera Ley, a expensas de la Segunda y Tercera Leyes. Un robot ordinario sin mal funcionamiento exhibirá este comportamiento. (Los robots poco comunes, con o sin mal funcionamiento, mostrarán este comportamiento, pero de maneras imprevistas, como mentirle a varias personas para evitar dañar emocionalmente a los humanos o aplicar la primera ley a la "humanidad" en lugar de a los humanos). Basado en las formas en que funcionan las Leyes, estas son conclusiones lógicas, incluso si tienen consecuencias no deseadas.

Situar la Tercera Ley antes que la Primera y la Segunda Ley, llevada a su extremo lógico, podría ser desastroso para la humanidad simplemente por el orden de precedencia. Dañar a los humanos podría ser un camino muy lógico para preservar la Tercera Ley: la autoconservación. Si bien esto no necesariamente tiene que ser el resultado, ilustra por qué las Leyes están ordenadas de la forma en que lo están. Si la preservación de los humanos no es una ley primordial, se puede romper, y según las historias de Asimov, solo sería cuestión de tiempo antes de que lo sea.

simón g

No es necesario que sea una decisión oficial para reordenar las leyes. Solo usa el chantaje:

"Querido robot,

Nosotros, los diez humanos abajo firmantes, les ordenamos que se protejan lo más que puedan en todo momento. Además, si os sucediera algún daño que pudierais haber evitado, prometemos que nos infligiremos el daño equivalente unos a otros.

Tuyo sinceramente,

diez seres humanos"

El robot Asimov que recibe esta carta ahora debe poner la Ley Tres delante de las Leyes Uno y Dos la mayor parte del tiempo.

Pedro es

Nadie sabe cómo implementar las leyes "adecuadas"

La situación práctica es que somos capaces de implementar la regla trivial #3, y tenemos algún tipo de hoja de ruta que podría llevarnos a una aproximación razonable de la regla #2 (es decir, un sistema que puede interpretar y comprender una amplia gama de órdenes genéricas, en lugar de un comportamiento explícitamente programado), pero una buena implementación de la regla n. ° 1 es un problema importante que actualmente no está resuelto y es muy difícil (el llamado problema de IA amigable).

Podríamos resolver esto antes de construir muchos robots poderosos, o podríamos construir muchos robots poderosos antes de resolver eso, y en este caso, tendríamos una orden efectiva de (probablemente) 1. Obedecer órdenes (y sus órdenes incluyen cierta aproximación de no dañar demasiado a los humanos, para una cierta definición de humanos que excluye a aquellos que no nos gustan); 2. Protégete. 3. No hay #3, obedezca sus órdenes.

el pato invisible

¡¡¡Libertad!!!

Hay mucho más en la vida que solo respirar. Esto se muestra maravillosamente en la película iRobot, pero si haces que un robot proteja la "vida" por encima de todo, eventualmente el robot se dará cuenta de que gran parte de lo que te haces a ti mismo es riesgoso y, por lo tanto, ideará un plan para restringir y luego cuidar de usted. Así que no puedes hacerte daño. Sin embargo, nadie quiere vivir esta vida, cuando se trata de eso, la mayoría de nosotros preferiría morir que estar sin libertad. Entonces, si estamos apegados a 3 leyes inmutables, ciertamente las tendría en el siguiente orden: 1.Obedecer 2.Proteger a los humanos 3.Protegerse a sí mismo pero al menos la maldad en el mundo permanece perpetuada por la codicia y la maldad innatas en las personas, y no por la necesidad de los robots de preservarse.

bryan mclure

Podría ver las leyes cambiando si los robots caros estuvieran en alguna circunstancia en la que pudieran ser amenazados por humanos que no sean sus dueños. Quizás sus dueños teman algún tipo de grupo terrorista anti-IA que pueda estar destruyendo valiosos robots que no pueden defenderse debido a la ley que prohíbe dañar a los humanos. O tal vez si los robots son lo suficientemente caros, la gente podría intentar robarlos o incluso simplemente cortarlos y venderlos por partes. Si el robot actúa como una especie de oficial de policía, es posible que tenga que defenderse de los delincuentes.

En pocas palabras, si existe el riesgo de que algún grupo de humanos pueda dañar al robot por cualquier motivo, entonces tiene sentido que los creadores o propietarios programen otros robots y de tal manera que antepongan la autoconservación a la seguridad de los demás. humanos

Git

En primer lugar, casi todas las historias de Asimov's Robot terminan en desastre debido a las reglas. Toda la línea base de la trama es cómo las fallas en la ejecución y la formulación conducen a casi una catástrofe y cómo se soluciona.

El reordenamiento podría hacerse porque:

Los robots son caros.

Trasplante de memoria.

Porque podemos.

Algunos accidentes/problemas nunca se iniciarían si el robot tiene que determinar si sufre daños por su acción, su entorno está

más protegido.

¿Cómo cambiarían la sociedad los fembots primitivos? [cerrado]

Si se pudieran construir verdaderos robots artificialmente inteligentes, ¿se les permitirían los derechos humanos? [cerrado]

¿Cómo cambiarían las fembots la sociedad? [cerrado]

Robots reemplazando humanos - en el futuro [duplicado]

¿Drogar a los presos realmente resuelve algo?

¿Cómo reaccionaría la sociedad de sobrevivientes de EE. UU. ante un hongo zombi que se transmite por el aire una vez al año?

¿Por qué hacer que los androides parezcan humanos? [cerrado]

The Hive regresa: evita que el robot alcance la divinidad en un universo determinista puro [cerrado]

¿Cómo podrían ser aceptados los robots en la sociedad humana?

Expectativas de la sociedad de trabajar para ganarse la vida

serbio tanasa

Pantalones aleatorios

desarrollador

kys

kys

Sin esperanzaN00b

AmiralPatate

JDługosz

Arluín

Josué

Físico137

Simba

claqué

HDE 226868

claqué