¿Cómo se compara el ojo humano con las cámaras y lentes modernas?

mattdm

Un objetivo en la mayoría de las fotografías es presentar una escena que se asemeje a lo que habría visto una persona que hubiera estado allí en ese momento. Incluso cuando se trabaja intencionalmente fuera de eso, la visión humana es la línea de base de facto.

Por lo tanto, parece útil saber algo sobre cómo se compara el ojo con nuestra tecnología de cámara. Dejando de lado los temas de psicología, reconocimiento de patrones y percepción del color tanto como sea posible (¡porque esa es una pregunta aparte!), ¿Cómo se compara el ojo humano con una cámara y una lente modernas?

¿Cuál es la resolución efectiva? ¿Campo de visión? ¿Apertura máxima (y mínima)? ¿equivalencia ISO? ¿Gama dinámica? ¿Tenemos algo que sea equivalente a la velocidad de obturación?

¿Qué estructuras son directamente análogas a las partes de una cámara y una lente (por ejemplo, la pupila y el iris) y qué características son exclusivamente humanas (o se encuentran en las cámaras pero no en la biología)?

Respuestas (4)

thomasrutter

El ojo humano realmente apesta en comparación con las lentes de las cámaras modernas.

El sistema visual humano , por otro lado, supera con creces cualquier sistema de cámara moderno (lente, sensor, firmware).

El ojo humano solo es nítido en el centro. De hecho, solo es nítido en un punto muy, muy pequeño conocido como fóvea , que es un punto cuyo diámetro es inferior al uno por ciento de nuestro ángulo de visión total. Así que tenemos una gran suavidad en las esquinas.

Sin embargo, el cerebro humano es capaz de corregir esto. Le indica al ojo que haga movimientos muy rápidos alrededor de una escena para que la parte afilada en el medio se mueva rápidamente. Entonces, el cerebro tiene una estabilización de imagen en el cuerpo bastante impresionante, porque toma todos estos movimientos rápidos y los une para crear una escena nítida;

El ojo humano es bastante sensible a la luz, pero a niveles bajos de luz no hay información de color disponible. Además de esto, la parte afilada en el centro (la fóvea) es menos sensible a la luz.

Técnicamente se debe a que el ojo tiene fotositos separados llamados conos para los tres colores (rojo, verde, azul) y otro tipo diferente de fotositos llamados bastones que solo capturan el blanco y el negro, pero es mucho más eficiente.

El cerebro une todo esto para crear una excelente imagen a todo color durante el día, pero incluso cuando está muy, muy oscuro, genera una imagen suave e incolora creada por todos los bastones.

El ojo solo tiene un elemento de lente y produce una terrible aberración cromática en forma de franjas moradas.

En realidad, esta franja está toda en longitudes de onda de luz muy cortas. El sistema visual humano es menos sensible a estos azules y violetas. Además de esto, es capaz de corregir esa franja que existe de varias maneras. Primero, porque el sistema de visión humano solo es nítido en el medio, y ahí es donde hay menos aberración cromática. Y en segundo lugar, porque nuestra resolución de color es (fuera de la fóvea) mucho más baja que nuestra resolución de brillo, y el cerebro no tiende a usar el azul cuando calcula el brillo.

Podemos ver en tres dimensiones. Esto se debe en parte a que tenemos dos ojos y el cerebro puede hacer cálculos sorprendentes relacionados con la convergencia entre ellos. Pero también es más avanzado que eso; Además del "efecto 3D" que obtienes de la visión estéreo, el cerebro también puede reconstruir escenas en tres dimensiones incluso cuando mira una foto bidimensional de la escena. Es porque comprende pistas como la oclusión, las sombras, la perspectiva y las pistas de tamaño y las utiliza para armar la escena como un espacio 3D. Cuando miramos una foto de un pasillo largo, podemos ver que el pasillo se aleja de nosotros aunque no tengamos visión estereoscópica, porque el cerebro entiende la perspectiva.

clabacchio

PearsonArteFoto

(Con mucha ayuda del artículo de Wikipedia )

Nuestros ojos son un sistema de 2 lentes, el primero es nuestro ojo externo y el segundo es una lente justo dentro de nuestro ojo. Nuestro ojo tiene una distancia focal fija, de unos 22-24 mm. Tenemos una resolución significativamente más alta cerca del centro que en los bordes. La resolución varía significativamente según el lugar de la imagen que esté mirando, pero es de alrededor de 1,2 minutos de arco/par de líneas en la región central. Tenemos alrededor de 6-7 millones de sensores, por lo que tenemos 6-7 megapíxeles, pero son algo diferentes. El patrón de los detectores de color no es muy uniforme, hay diferentes capacidades de detección de color en el centro en comparación con la visión periférica. El campo de visión es de unos 90 grados desde el centro.

Un punto interesante es que el ojo humano nunca forma una "instantánea" completa, sino que es más un sistema continuo. Puede ser muy difícil decir esto, porque nuestros cerebros son muy buenos para corregirlo, pero nuestro sistema es más un enfoque de balde con fugas para la fotografía, algo similar, pero no exactamente, a una videocámara digital.

La lente "Normal" generalmente se elige para representar el área principal del enfoque humano, lo que explica sus diferencias.

Las cámaras tienen diferentes tipos de sensores, pero generalmente se distribuyen de manera bastante uniforme alrededor del sensor. El sensor siempre es plano (el sensor humano es curvo), lo que puede provocar distorsiones en los bordes. La resolución es difícil de obtener en el mismo formato que se da a la visión humana, y depende un poco de la lente, pero se puede decir con seguridad que el ojo humano tiene más resolución en el centro de su foco, pero menos en las áreas periféricas.

jrista

Zachary K.

decasteljau

Pixiq tiene un artículo muy interesante sobre el tema, publicado hace unos días: http://web.archive.org/web/20130102112517/http://www.pixiq.com/article/eyes-vs-cameras

Hablan de la equivalencia ISO, enfoque, apertura, velocidad de obturación, etc... Es tema de discusión, pero sigue siendo interesante de leer.

El ojo en sí mismo es una buena pieza de tecnología, pero el cerebro hace gran parte del trabajo al ensamblar las piezas. Por ejemplo, podemos percibir un rango dinámico muy grande, pero esto se debe principalmente a que el cerebro ensambla las diferentes regiones sin que nos demos cuenta. Lo mismo para la resolución, el ojo tiene una buena resolución en el centro, pero realmente tiene un rendimiento inferior en el resto. El cerebro ensambla los detalles por nosotros. Lo mismo ocurre con los colores, solo percibimos colores en el centro, pero el cerebro nos engaña almacenando información de color cuando se salen del alcance del centro.

bosque

Déjame responderte una pregunta: ¿Cuál es la tasa de bits y la profundidad de bits de un disco de vinilo?

Las cámaras son dispositivos diseñados para reproducir, con la mayor fidelidad posible, la imagen que se proyecta en su CCD. Un ojo humano es un dispositivo evolucionado cuyo propósito es simplemente mejorar la supervivencia. Es bastante complejo y, a menudo, se comporta de forma contraria a la intuición. Tienen muy pocas similitudes:

- Una estructura óptica para enfocar la luz.

- Una membrana receptiva para detectar la luz proyectada.

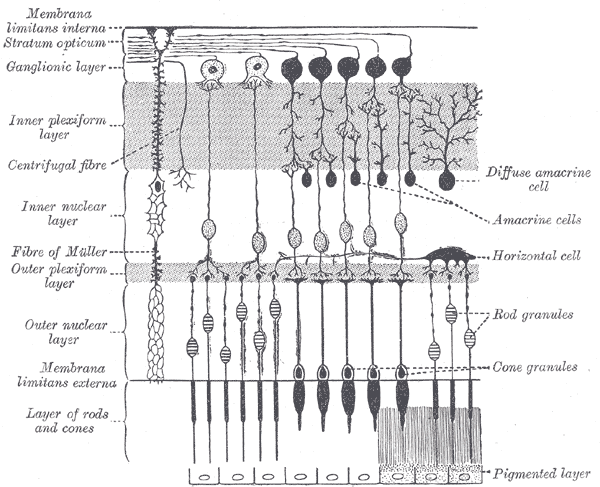

Los fotorreceptores de la retina

El ojo en sí no es notable. Tenemos millones de fotorreceptores, pero proporcionan entradas redundantes (¡y ambiguas al mismo tiempo!) a nuestro cerebro. Los fotorreceptores de varilla son muy sensibles a la luz (especialmente en el lado azulado del espectro) y pueden detectar un solo fotón. En la oscuridad, funcionan bastante bien en un modo llamado visión escotópica. A medida que se vuelve más brillante, como durante el crepúsculo, las células del cono comienzan a despertarse. Las células cónicas requieren alrededor de 100 fotones como mínimo para detectar la luz. Con este brillo, tanto los bastones como los conos están activos, en un modo llamado visión mesópica. Las celdas de varilla proporcionan una pequeña cantidad de información de color en este momento. A medida que se vuelve más brillante, los bastones se saturan y ya no pueden funcionar como detectores de luz. Esto se llama visión fotópica y solo funcionarán las células cónicas.

Los materiales biológicos son sorprendentemente reflectantes. Si no se hiciera nada, la luz que pasa a través de nuestros fotorreceptores y golpea la parte posterior del ojo se reflejaría en ángulo, creando una imagen distorsionada. Esto se soluciona con la capa final de células en la retina que absorben la luz usando melanina. En los animales que requieren una gran visión nocturna, esta capa es intencionalmente reflectante, por lo que los fotones que pierden los fotorreceptores tienen la oportunidad de golpearlos en su camino de regreso. ¡Por eso los gatos tienen retinas reflectantes!

Otra diferencia entre una cámara y el ojo es dónde se ubican los sensores. En una cámara, se ubican inmediatamente en el camino de la luz. En el ojo, todo está al revés. El circuito de la retina se encuentra entre la luz y los fotorreceptores, por lo que los fotones deben pasar a través de una capa de todo tipo de células y vasos sanguíneos antes de golpear finalmente un bastón o un cono. Esto puede distorsionar la luz ligeramente. Afortunadamente, nuestros ojos se calibran automáticamente, por lo que no nos quedamos atrapados mirando un mundo con vasos sanguíneos de color rojo brillante que se mueven de un lado a otro.

La fóvea, en el centro de la retina, es donde tiene lugar toda la recepción de alta resolución, y la periferia se vuelve cada vez menos sensible a los detalles y cada vez más daltónica (aunque más sensible a pequeñas cantidades de luz y movimiento). ). Nuestro cerebro se ocupa de esto moviendo rápidamente los ojos en un patrón muy sofisticado que nos permite obtener el máximo detalle del mundo. En realidad, una cámara es similar, pero en lugar de usar un músculo, toma muestras de cada receptor CCD a su vez en un patrón de escaneo rápido. Este escaneo es mucho, mucho más rápido que nuestro movimiento sacádico, pero también está limitado a un solo píxel a la vez. El ojo humano es más lento (y el escaneo no es progresivo ni exhaustivo), pero puede captar mucho más a la vez.

Preprocesamiento realizado en la retina.

La propia retina en realidad hace bastante preprocesamiento. La disposición física de las celdas está diseñada para procesar y extraer la información más relevante.

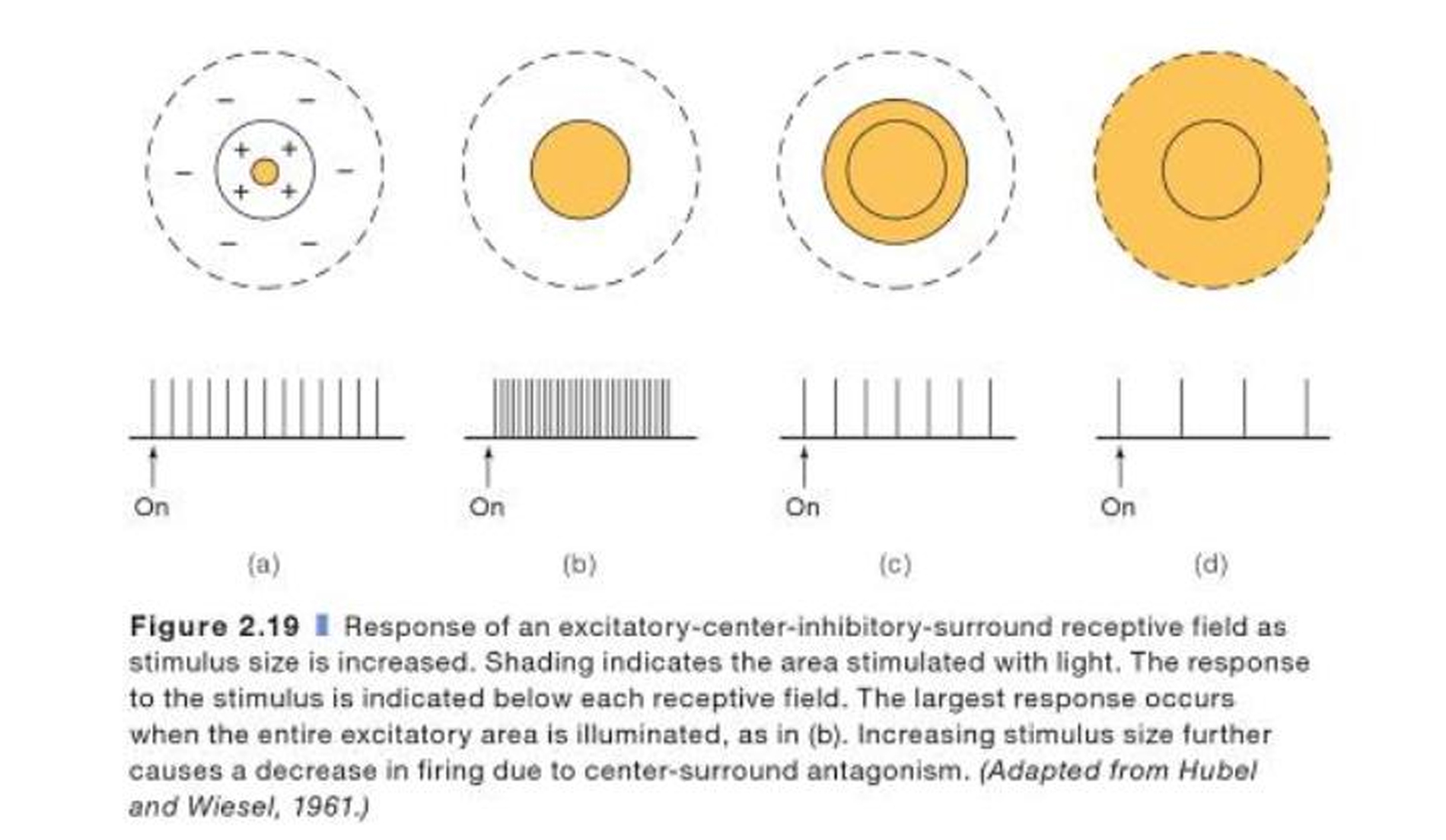

Si bien cada píxel en una cámara tiene una asignación 1:1 al píxel digital que se almacena (al menos para una imagen sin pérdidas), los bastones y conos en nuestra retina se comportan de manera diferente. Un solo "píxel" es en realidad un anillo de fotorreceptores llamado campo receptivo. Para entender esto, se requiere una comprensión básica del circuito de la retina:

Los componentes principales son los fotorreceptores, cada uno de los cuales se conecta a una sola célula bipolar, que a su vez se conecta a una célula ganglionar que llega al cerebro a través del nervio óptico. Una célula ganglionar recibe información de múltiples células bipolares, en un anillo llamado campo receptivo central-envolvente. El centro del anillo y el borde del anillo se comportan como opuestos. La luz que activa el centro excita la célula ganglionar, mientras que la luz que activa el entorno la inhibe (un campo en el centro, fuera del entorno). También hay células ganglionares para las que esto se invierte (fuera del centro, alrededor).

Esta técnica mejora considerablemente la detección de bordes y el contraste, sacrificando la agudeza en el proceso. Sin embargo, la superposición entre los campos receptivos (un solo fotorreceptor puede actuar como entrada para múltiples células ganglionares) permite que el cerebro extrapole lo que está viendo. Esto significa que la información que se dirige al cerebro ya está altamente codificada, hasta el punto en que una interfaz cerebro-computadora que se conecta directamente al nervio óptico no puede producir nada que podamos reconocer. Está codificado de esta manera porque, como han mencionado otros, nuestro cerebro proporciona increíbles capacidades de procesamiento posterior. Dado que esto no está directamente relacionado con el ojo, no daré más detalles sobre ellos. Lo básico es que el cerebro detecta líneas individuales (bordes), luego sus longitudes, luego su dirección de movimiento, cada una en áreas posteriormente más profundas de la corteza,corriente ventral y corriente dorsal , que sirven para procesar color y movimiento de alta resolución, respectivamente.

La fóvea central es el centro de la retina y, como han señalado otros, es de donde proviene la mayor parte de nuestra agudeza. Contiene solo células cónicas y, a diferencia del resto de la retina, tiene un mapeo 1:1 de lo que vemos. Un fotorreceptor de un solo cono se conecta a una sola célula bipolar que se conecta a una sola célula ganglionar.

Las especificaciones del ojo

El ojo no está diseñado para ser una cámara, por lo que no hay forma de responder a muchas de estas preguntas de la forma que desee.

¿Cuál es la resolución efectiva?

En una cámara, hay una precisión bastante uniforme. La periferia es tan buena como el centro, por lo que tiene sentido medir una cámara por la resolución absoluta. El ojo, por otro lado, no solo no es un rectángulo, sino que diferentes partes del ojo ven con diferente precisión. En lugar de medir la resolución, los ojos se miden con mayor frecuencia en VA . Un 20/20 VA es promedio. Un 20/200 VA te hace legalmente ciego. Otra medida es LogMAR , pero es menos común.

¿Campo de visión?

Al tener en cuenta ambos ojos, tenemos un campo de visión horizontal de 210 grados y un campo de visión vertical de 150 grados. 115 grados en el plano horizontal son capaces de visión binocular. Sin embargo, solo 6 grados nos proporciona una visión de alta resolución.

¿Apertura máxima (y mínima)?

Típicamente, la pupila tiene 4 mm de diámetro. Su rango máximo es de 2 mm ( f/8.3 ) a 8 mm ( f/2.1 ). A diferencia de una cámara, no podemos controlar manualmente la apertura para ajustar cosas como la exposición. Un pequeño ganglio detrás del ojo, el ganglio ciliar, ajusta automáticamente la pupila según la luz ambiental.

¿equivalencia ISO?

No puede medir esto directamente, ya que tenemos dos tipos de fotorreceptores, cada uno con una sensibilidad diferente. Como mínimo, somos capaces de detectar un solo fotón (aunque eso no garantiza que un fotón que incide en nuestra retina impacte en un bastón). Además, no ganamos nada mirando algo durante 10 segundos, por lo que la exposición adicional significa poco para nosotros. Como resultado, ISO no es una buena medida para este propósito.

Una estimación aproximada de los astrofotógrafos parece ser 500-1000 ISO, con un ISO de luz diurna tan bajo como 1. Pero nuevamente, esta no es una buena medida para aplicar al ojo.

¿Gama dinámica?

El rango dinámico del ojo en sí mismo es dinámico, ya que entran en juego diferentes factores para la visión escotópica, mesópica y fotópica. Esto parece estar bien explorado en ¿Cómo se compara el rango dinámico del ojo humano con el de las cámaras digitales? .

¿Tenemos algo que sea equivalente a la velocidad de obturación?

El ojo humano es más como una cámara de video. Toma todo a la vez, lo procesa y lo envía al cerebro. El equivalente más cercano que tiene a la velocidad de obturación (o FPS) es el CFF , o Critical Fusion Frequency, también llamado Flicker Fusion Rate. Esto se define como el punto de transición donde una luz intermitente de frecuencia temporal creciente se mezcla en una sola luz sólida. El CFF es más alto en nuestra periferia (es por eso que a veces solo se puede ver el parpadeo de las bombillas fluorescentes viejas si se miran indirectamente), y es más alto cuando hay mucha luz. En luz brillante, nuestro sistema visual tiene un CFF de alrededor de 60. En la oscuridad, puede llegar a 10.

Sin embargo, esta no es toda la historia, porque gran parte de esto es causado por la persistencia visual en el cerebro. El ojo en sí tiene un CFF más alto (aunque no puedo encontrar una fuente en este momento, creo recordar que está en el orden de magnitud de 100), pero nuestro cerebro difumina las cosas para disminuir la carga de procesamiento y darnos más tiempo. para analizar un estímulo transitorio.

Tratando de comparar una cámara y el ojo

Los ojos y las cámaras tienen propósitos completamente diferentes, aunque superficialmente parezcan hacer lo mismo. Las cámaras se construyen intencionalmente en torno a suposiciones que facilitan ciertos tipos de medición, mientras que tal plan no entró en juego para la evolución del ojo.

Técnicamente, ¿por qué el área desenfocada se ve más borrosa cuando se usa una apertura más grande?

¿Por qué el ojo humano no presenta aberraciones?

¿Una lente macro tiene un DOF más pequeño en distancias del 'mundo real' a la misma distancia focal y apertura que otros lentes fijos? ¿Por qué?

¿Cómo producen las lentes anamórficas "rayas" de destello de lente?

¿Los fotógrafos ven ambigüedad en el color del vestido azul/negro (dorado/blanco)?

Esquinas negras bien definidas con algunas fotos con superzoom

Uso de adaptadores DOF en fotografía fija

Configuración del balance de blancos para que coincida con la forma en que percibimos las cosas

¿Se pueden describir todos los colores con RGB?

Una cámara delgada y una lente delgada con un gran elemento de vidrio

José Nuno Ferreira

José Nuno Ferreira

mattdm

tomm89

JYelton

Mella

mattdm

jrista

Mella

mattdm

mattdm

mattdm

mattdm