¿Cómo determinan los científicos cuándo descartar un modelo que tiene una mayor correlación con los datos que otro modelo?

Anónimo

Para cualquier conjunto de puntos de datos, puede componer una curva 100 % correlacionada y ajustada utilizando una suma de líneas inclinadas, todas multiplicadas por sus respectivas funciones de paso de Heaviside para formar una curva en forma de zigzag. Y, sin embargo, no usamos esos modelos. Esto plantea la pregunta: ¿cómo sabe la comunidad científica académica de físicos cuándo descartar un modelo que tiene una correlación más alta que otro modelo posible?

Respuestas (5)

ana v

Para cualquier conjunto de puntos de datos, puede componer una curva 100% interpolada y ajustada utilizando una suma de líneas inclinadas, todas multiplicadas por sus respectivas funciones de paso de Heaviside para formar una curva en forma de zig-zag. Y, sin embargo, no usamos esos modelos.

La física desde la época de Newton hasta ahora es la disciplina donde se utilizan ecuaciones diferenciales matemáticas, cuyas soluciones se ajustan a los puntos de datos y son predictivas de nuevos datos. Para ello, se escoge un subconjunto de las posibles soluciones matemáticas mediante el uso de postulados/leyes/principios, tan fuertes como axiomas en cuanto al ajuste de los datos.

Lo que describe es un ajuste aleatorio a una curva de datos determinada y no hay posibilidad de predecir el comportamiento de nuevos sistemas y condiciones de contorno. No es un modelo.

¿Cómo sabe la comunidad científica académica de físicos cuándo descartar un modelo que tiene una correlación más alta que otro modelo posible?

Si uno tiene un conjunto completo de funciones, como las funciones de Fourier o Bessel, siempre puede ajustar las curvas de datos. este no es un modelo de física, es solo un algoritmo para registrar datos. El modelo de física tiene que predecir qué coeficientes tendrán las funciones que se utilizan para un ajuste.

alefcero

a la izquierda

La "correlación más alta" no tiene sentido más allá de cierto punto; es decir, cuando ambos modelos ya son tan buenos que todos los puntos de datos concuerdan con la predicción del modelo dentro de los límites de su incertidumbre de medición . Entonces, el modelo que se acerca aún más, "innecesariamente cerca" a los valores esperados de medición individuales, no es el mejor modelo. De hecho, se considera inferior, es decir, sobreajustado : algunas de las características del modelo serán atribuibles a errores de medición aleatorios en lugar del comportamiento "inherente" del sistema.

Ahora, eso no es necesariamente un problema. En algunas aplicaciones, particularmente en ingeniería, está perfectamente bien solo medir el sistema particular que le interesa y registrar la curva de la manera que describió. Entonces tienes un modelo muy bueno para ese sistema y puedes hacer todas las predicciones sobre cómo se comportará ese sistema en tal o cual estado. Es un modelo un poco "caro", en el sentido de que necesita almacenar una gran cantidad de datos en lugar de solo una fórmula breve, pero bueno, si es ingeniero y sus clientes están contentos, ¿a quién le importa?

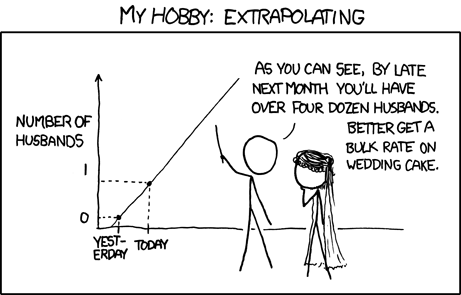

Sin embargo, las cosas son un poco diferentes en física . Aquí, buscamos hacer todas las leyes tan generales como sea posible. La mayoría de las cosas que podemos medir en el laboratorio no son realmente lo que queremos describir, sino más bien un prototipo simplificado de las cosas que realmente nos interesan (pero que no podemos medir directamente). Básicamente, lo que queremos hacer es extrapolar los resultados de laboratorio al mundo real. Ahora bien, la extrapolación es un negocio peligroso ... en particular, diferentes modelos que se ajustan a los mismos datos pueden dar lugar a extrapolaciones muy diferentes. Entonces, ¿cómo podemos saber qué modelo de este tipo realmente dará predicciones correctas ?

La respuesta es que no podemos : si supiéramos los valores correctos que se van a predecir, ¡no necesitaríamos extrapolar en primer lugar! Sin embargo, podemos aplicar la navaja de Occam y eso tiende a ser bastante efectivo en este negocio. Básicamente, la idea es: un modelo complicado que requiere muchos parámetros de ajuste no es una buena apuesta para la extrapolación (si puede encontrar uno de esos modelos, es probable que también pueda encontrar un modelo similar, pero estructurado de manera diferente, que se comporte completamente diferente tan pronto como sea posible). deja el dominio de medición original). OTOH, un modelo simple y elegante dado, por ejemplo, como una ecuación diferencial simple tiene buenas posibilidades de ser el únicomodelo tan simple que en realidad es capaz de ajustar los datos, por lo tanto, puede ser optimista de que sus extrapolaciones también estarán cerca de una ventana de expectativa más amplia y precisa.

Fotón

Dos pensamientos vienen a la mente:

Una teoría tiene que describir más de un conjunto de datos. Si ajusta su "teoría" para que se ajuste perfectamente a un experimento, lo más probable es que falle en otro. En particular, si considera diferentes tipos de experimentos (digamos, mide la caída de una manzana y el movimiento de la luna).

Una teoría debe tener algo de belleza. Esto significa que debe haber algún concepto simple detrás de él, para que tenga la sensación de que "explica" las cosas en lugar de simplemente dar una fórmula incomprensible que se ajuste al experimento. Por supuesto, ninguna teoría puede explicarlo todo, toda teoría necesita algunos axiomas, algunos ansatz. Pero la mejor teoría explica más observaciones con menos suposiciones.

usuario121330

Rococó

Fotón

Fotón

jk.

Pantalones aleatorios

Fotón

Barmar

Su pregunta es esencialmente sobre el problema de la inducción . Esta es una pregunta filosófica sobre cómo podemos generalizar y formar una teoría a partir de un conjunto limitado de puntos de datos. Hay un número infinito de curvas que se ajustan a los datos (y aún más infinitas si permitimos márgenes de error), entonces, ¿cómo sabemos cuál es?

La respuesta general es que hacemos experimentos adicionales. Una teoría solo es útil si hace predicciones, en lugar de simplemente describir los datos dados. Entonces, después de formar una teoría que describe los datos, hacemos más experimentos y vemos si esos resultados son consistentes con la teoría. Si no lo son, sabemos que la teoría estaba equivocada y se puede descartar.

Esta es la razón por la cual las teorías que no pueden probarse de esta manera a menudo se denominan no científicas; un ejemplo popular es el Multiverso: según algunas definiciones, no hay forma de saber si existen o no otros universos (si pudiera detectarse, lo consideraríamos parte de nuestro universo). Un área borrosa son las teorías que, en principio, podrían probarse, pero tales pruebas no son factibles con ninguna tecnología que esperamos que esté disponible; algunos científicos llaman a la Teoría de Cuerdas "ni siquiera equivocada" debido a esto.

El método científico nunca puede "probar" completamente una teoría, siempre es posible que surja algún nuevo punto de datos que no se ajuste a la teoría, y tendrá que ser revisado o descartado. Por ejemplo, la órbita de Mercurio no se ajusta a la mecánica newtoniana; La Teoría General de la Relatividad de Einstein resolvió esto (los astrónomos sospechaban previamente que había otro planeta perturbando la órbita de Mercurio). Pero cada vez que obtenemos nuevos datos que se ajustan a un modelo, aumentamos nuestra confianza en él; Einstein se hizo mundialmente famoso cuando las observaciones del Sol desviando la trayectoria de la luz de estrellas distantes durante un eclipse coincidieron exactamente con la predicción de la Relatividad General.

Así que esto nos lleva a su pregunta. Cada modelo hace predicciones y, presumiblemente, los diferentes modelos hacen predicciones diferentes. Así que hacemos experimentos adicionales, para ver cuál de las predicciones se confirma, y luego descartamos la otra.

bob.sacamento

Esta no es una pregunta que tenga una respuesta simple. La respuesta corta es "experiencia", pero si quieres algo más allá y estás listo para leer cosas esotéricas reales, te sugiero que mires a los filósofos de la ciencia Popper, Polanyi y Kuhn.

AnoE

Rococó

bob.sacamento

AnoE

Combinar dos puntos de datos con diferentes incertidumbres

¿Por qué trazamos distribuciones (histogramas, etc.) por intervalo logarítmico (es decir, por "dec"/"dex")?

¿Cuál es la forma 'correcta' de determinar la incertidumbre de un valor promedio a partir de múltiples mediciones?

¿Por qué no usamos el error absoluto al calcular el producto de dos cantidades inciertas?

Medidas y errores

Convención estándar para barras de error xxx

¿Cómo se fabrican instrumentos más precisos usando solo instrumentos menos precisos?

Pregunta sobre la interpretación de los campos de metadatos de los conjuntos de datos de sección transversal de partículas PDG

Experimentos cuantitativos fáciles de realizar en casa [cerrado]

Análisis de error simple para la relación de caudales en un tubo

quimiomecánica

miridio

Geoffrey

usuario165197

Dmitri Grigoriev

Meni Rosenfeld

rana globo ocular